|

|||

|

|||

Accueil > Forum TERATEC > Sessions plénières

09h00 - 9h10 : Ouverture du Forum TERATEC 2012

Gérard ROUCAIROL, Président de TERATEC et Vice-président de l’ACADEMIE DES TECHNOLOGIES

9h10 - 9h25 : David ROS, Vice-président, CONSEIL GENERAL DE L’ESSONNE

9h25 - 9h55 : Philippe GILLET,Vice-président, ECOLE POLYTECHNIQUE FEDERALE DE LAUSANNE

9h55 - 10h25 :

Anthony LICHNEWSKY, Software Architect- HPC Specialist, SCHLUMBERGER

La demande énergétique mondiale va augmenter d’un tiers d’ici à 2040, tirée par la consommation des pays hors OCDE. Le pétrole et le gaz naturel vont, selon toutes les projections, devoir satisfaire la majorité de cette demande. Pour ce faire, les industries d’exploration et production pétrolières font appel a des technologies de pointe, et en particulier, au calcul intensif. Par exemple, de nouvelles techniques d’imagerie pour identifier des gisements dans des zones géologiques de plus en plus complexes. De la simulation et de l’imagerie en temps réel pour guider, optimiser et réduire les risques durant le forage des puits. Des modèles de réservoirs de plus en plus complexes pour optimiser la production d’un champ. Dans un premier temps, je présenterai une vue d’ensemble de l’industrie et de ses défis, puis je détaillerai les contributions du calcul intensif.”

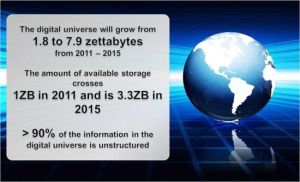

11h30 - 12h00 : From Petabytes (1015) to Yottabytes (1024), and before 2020

Steve BARBER, Chief Executive Officer , XYRATEX

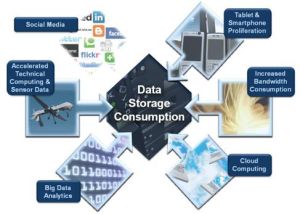

Data Storage Consumption is Growing

There is no denying the need for storage. Digital data continues to grow at explosive rates driven by macro themes including: Cloud, Social Media, Tablets, Increased Bandwidth, Data Analytics & Technical Computing. The pace of user generated content and the fire hose of information availability puts market statistics out of date quickly. IDC estimates that 70% of the “Digital Universe” is created by consumers; however, enterprises are liable for managing 80% of the data of which a significant portion is stored on disk drives.

|

The insatiable appetite for online data continues to grow about 50% year over year (IDC). Web browsing, audio/video streaming and a variety of other applications are driving bandwidth consumption from fixed and mobile devices. The proliferation of tablets and smart phones shipments has now exceeded that of PC’s and this trend will not reverse. The build out of cloud environments is forecasted to be over $200 billion in 2020. Big Data Analytics is expected to reach ~$17 billion in 2015. Social media has significant influence on data storage consumption as it drives applications connected to mobile devices, cloud, and often times requires increased bandwidth. |

|---|---|

|

Technical Computing (e.g. High Performance Computing) is a dynamic opportunity as it grows in both traditional simulation, and lab/research environments as well outside of traditional HPC markets as these technologies become more accessible to other industrial markets such as Cloud, and other Big Data application needs. The emerging Exascale needs will require a new approach to handling the performance and scale requirements that are anticipated. For example the Square Kilometre Radio Telescope Array will write 1Exabyte per day. That is more than 10 TB / sec sustained! Presently that requires 100,000 disks, which is considered to be close to unmanageable. Just scaling up won't resolve the issue, we’ll need to be smarter with more data management. |

12h00 - 12h30 : New Opportunities for HPC - Cloud, Analytics, Big Data

Ananth KRISHNAN, CTO, TATA CONSULTANCY SERVICES

14h15 - 14h45 : Simulation Numérique: l'atout majeur de l’innovation dans la chimie et les polymères

David SILAGY, Directeur de centre de recherche, ARKEMA

Arkema, leader français de la chimie à vocation mondiale, apporte des solutions innovantes à toutes les autres industries, en particulier sur les sujets-clés du développement durable, qu’il s’agisse des énergies nouvelles, du stockage de l’énergie, des matières premières bio-sourcées ou de l’allégement des matériaux. La simulation numérique permet à Arkema d’optimiser et de raccourcir le cycle d’innovation et d’améliorer le service rendu à nos clients sous différents aspects. Nous utilisons ainsi la simulation numérique à plusieurs niveaux d’échelle: au niveau microscopique, pour l’acquisition de propriétés physiques et thermodynamiques des corps, au niveau mésoscopique pour l’optimisation des phases de pilotage et à l’échelle macroscopique pour la conception virtuelle des matériaux polymères ou des procédés. La complexité des processus physico-chimique qui régissent l’industrie chimique: fluide non newtonien, matériaux composites, phénomènes interfaciaux, milieux réactionnels, cadre multiphasique complexe, limite la précision des simulations numériques actuelles. L’accès à des ressources CPU importantes devient alors un des enjeux majeurs pour conduire à une modélisation prédictive. Le présent exposé illustrera des utilisations pratiques de la simulation numérique au travers d’exemples concrets, dans des domaines tels que le contrôle en ligne des procédés de polymérisation, l’éco-conception de nouveaux matériaux polymères ou la modélisation de l’hydrodynamique dans les cuves agitées. Enfin nous évoquerons le point de vue d’une société de chimie sur les défis et les perspectives de progrès dans la simulation numérique.

14h45 - 15h15 :

Joel MONNIER, Président, KALRAY

Les besoins croissants en puissance de calcul de la plupart des applications embarquées se heurtent aux limites des technologies traditionnelles (microcontrôleurs, DSP, FPGA, circuits spécialisés, etc.) que ce soit en termes de capacité de calcul, de puissance consommée, de facilité de programmation et de temps de mise au point. L’évolution vers des architectures de calcul parallèles est donc une tendance lourde pour l’ensemble des domaines et en particulier pour les applications embarquées (traitement de signal, encodage vidéo, traitement d’image, modélisation 3D, calcul scientifique).

L’atteinte de très hauts niveaux de performance pour une puissance consommée modérée, impératif dans le domaine de l’embarqué, passe par une nouvelle génération de solutions intégrant plusieurs centaines ou milliers de cœurs de calcul sur chaque composant. Ce nouveau type de plateformes d’exécutions pour les systèmes embarqués constitue à la fois une rupture technologique par rapport aux solutions précédentes ainsi qu’une opportunité majeure pour le développement de nouvelles applications innovantes et l’émergence de nouveaux fournisseurs de technologie sur ce domaine.

Kalray MPPA® Developer |

La technologie MPPA™, développée par Kalray, est l’une des toutes premières plateformes d’exécution « manycore » pour l’embarqué. Sur la base de la technologie silicium la plus avancée (CMOS 28 nm), MPPA est un processeur intégrant 256 cœurs de calcul VLIW optimisés et permettant de déployer une puissance de calcul de 500 GOPS ou 200 GFLOPS pour une puissance consommée typique de 5 à 10W. applications de calcul numérique sont également en cours de développement. |

Les premiers kits de développement (MPPA Developer) seront livrés dès Q4 2012. Ils intègrent une carte de développement MPPA et un ensemble d’outils logiciels dans un environnement « tout en un » et prêt à l’emploi. Des cartes d’accélération PCI/Express intégrant plusieurs processeurs MPPA et visant plus spécifiquement les applications de calcul numérique sont également en cours de développement.

15h15 15h45 -

Bernard Querleux, Recherche avancée, L’OREAL Recherche & Innovation

L’Oréal, leader mondial des cosmétiques, a construit son développement en s’appuyant sur la performance avérée de ses produits, une performance issue d’un engagement fort de sa Recherche et Innovation.

La grande spécificité de la recherche en cosmétique résulte de la diversité des finalités (soin de la peau, maquillage, coloration et hygiène capillaire, …) qui conduit à une diversité des actifs et des formulations, et à la prise en compte des spécificités régionales des cheveux et des peaux du monde. Plus classiquement, nous devons réduire le cycle de développement de nos produits, et surtout viser l'abandon de tout recours à l’expérimentation animale pour l’évaluation de la sécurité et de l’efficacité de nos produits. Face à ces enjeux, la Recherche de L’Oréal s’est engagée depuis quelques années dans la mise en place d’une évaluation prédictive de la sécurité et de l’efficacité, élaborée à partir de technologies alliant l’ingénierie tissulaire, l’automatisation des plateformes de mesure, l’imagerie et la modélisation numérique.

Au moment où la Technopole Teratec souhaite élargir ses activités de calcul intensif au-delà des domaines habituels de l’énergie, l’aéronautique, l’automobile ou la défense, pour s’ouvrir par exemple aux problématiques scientifiques de la santé et du bien-être, nous présenterons quelques exemples concrets de réalisations dans le domaine de la modélisation, un outil stratégique permettant d'aborder différemment la maitrise de mécanismes chimiques, biologiques ou physiques.

Enfin, parce que la modélisation est au cœur d’une compréhension intégrée du système complexe que représente un actif au sein d’une formule et en interaction avec un substrat cosmétique, le recours au calcul intensif pour modéliser des systèmes de très grande taille s’imposera dans un temps certainement plus proche que nous ne l’imaginons.

Modélisation physique du mouvement de la chevelure. (Collaboration L’OREAL R&I, INRIA Rhône-Alpes)

16h15 - 16h45 : Nelson MACULAN, ancien ministre de l'Education du BRESIL et professeur à L’UNIVERSITE FEDERALE DE RIO-DE-JANEIRO

16h45 - 17h15 : Robert MADELIN, Director-General for Information Society and Media, COMMISSION EUROPÉENNE

17h15 - 17h45 : Prix Bull Joseph Fourier en association avec Genci